开yun体育网比如即便有双通说念音频-开云·kaiyun(中国)体育官方网站 登录入口

兔子通过两只耳朵不错准确感知捕食者的所作所为,训导了不同品种通俗漫衍谢宇宙各地的生命遗迹;相同东说念主也需要通过双耳千里浸式享受电影视听盛宴、判断驾驶环境和感知周围步履现象。

那应用火爆的diffusion生成模子是否不错作念到径直生成适合物理宇宙法例的空间音频呢?

此前,经典的Text2Audio的职责不错通过文本详尽的语义生成较为准确的单通说念音频。

然则这忽略了东说念主类与生俱来的感知双通说念音频的才调。应用角度来说,通过文本终结生成多通说念音频在影视文娱、AR/VR等范围领有毛病应用。

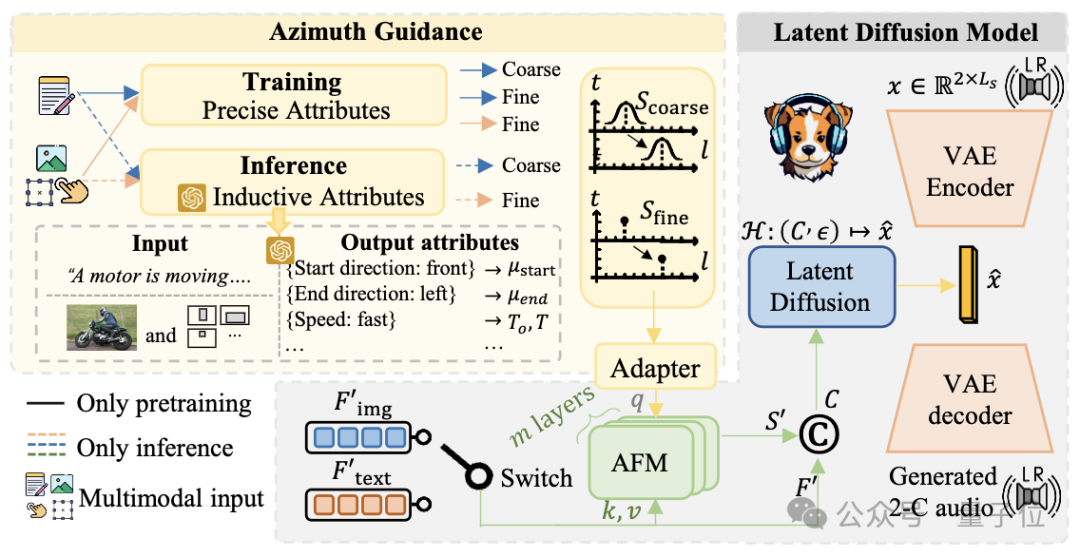

在这个趋势的布景下,为了增强文本关于多通说念音频生成的终结,港科大败邮团队初度从数据、模子和评价方法角度都革命性的将终结声源倡导纳入到生成范围内。

翻开新闻客户端 栽植3倍畅达度什么是空间音频生成?

什么是空间音频?

似乎能够通过声息判断事物倡导和现象是天然东说念主与生俱来的才调。生物声学 (Bioacoustics)是早在20世纪便进行了长远的探索。东说念主能感知声息的场地,主要来自以下三个方面:

ITD (主要不同):Interaural Time Difference-耳间时候差。即由于双耳耳间距离导致声息到达两只耳朵的时候不一样。这一丝是双通说念的主要各异。

ILD:Interaural Level Difference-耳间声强差。即由于双耳耳间距离导致声息到达两只耳朵的强度和衰减不一样。这一丝是赞助神志,在履行生成中发现这点较难度量,基本能量一致。

耳蜗、耳说念和头骨等生理结构:由于东说念主的感知系统特殊复杂,况且波及物理及生理接头,是一门特殊深的常识。在Bioacoustic范围,好多东说念主用深度学习门径构建合理的的HRTF (Head-related transfer function),才能够很好的模拟生理结构。然则鉴于本文为先期探索职责,文中不研讨这点的影响。

竣事空间音频生成联系的技巧阶梯?

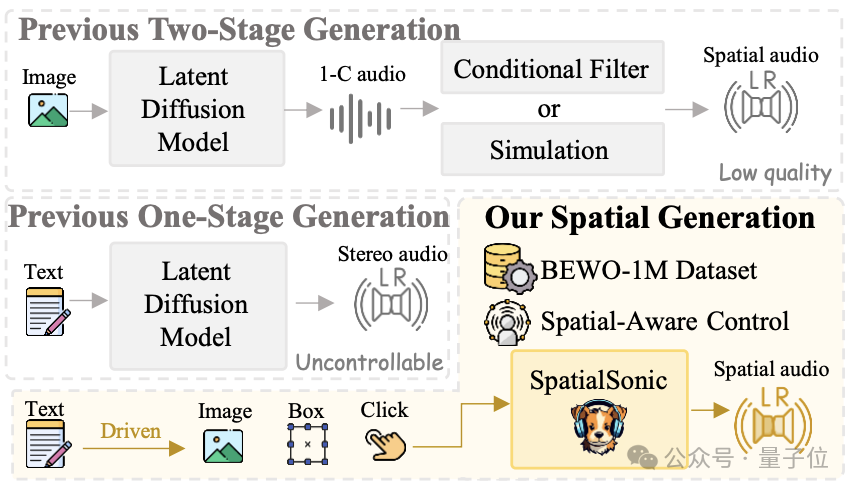

1、双阶段决议:领先通过普通text2audio的模子生成单通说念音频,然后通过仿真或者可学习的滤波器进行串联。使得最终能够取得多通说念的空间音频。这种系统显然不够鲁棒况且无法恰当复杂场景的生成任务。

2、此前的单阶段决议:天然这类系统能够生成stereo音频,然则远远不具备生成spatial音频的终结才调。

3、该接头决议:提议了从数据集、门径和评估接洽的一条龙处理决议,较好的栽植了关于spatial音频的终结。

数据构造:让机器“耳听八方”的数据工场

在本项接头中,数据构造是扫数系统的基石!

想要生成各个方进取的音频,就必须让生成模子透露方进取的永别。比如想要让系统生成摩托自左向右行进,就需要提供摩托在左、在右、自左向右和自右向左的音频让系统理会永别。这么音频汇注的老本显然瑕瑜常雄伟的,为什么不作念一个高效的“数据工场”呢?

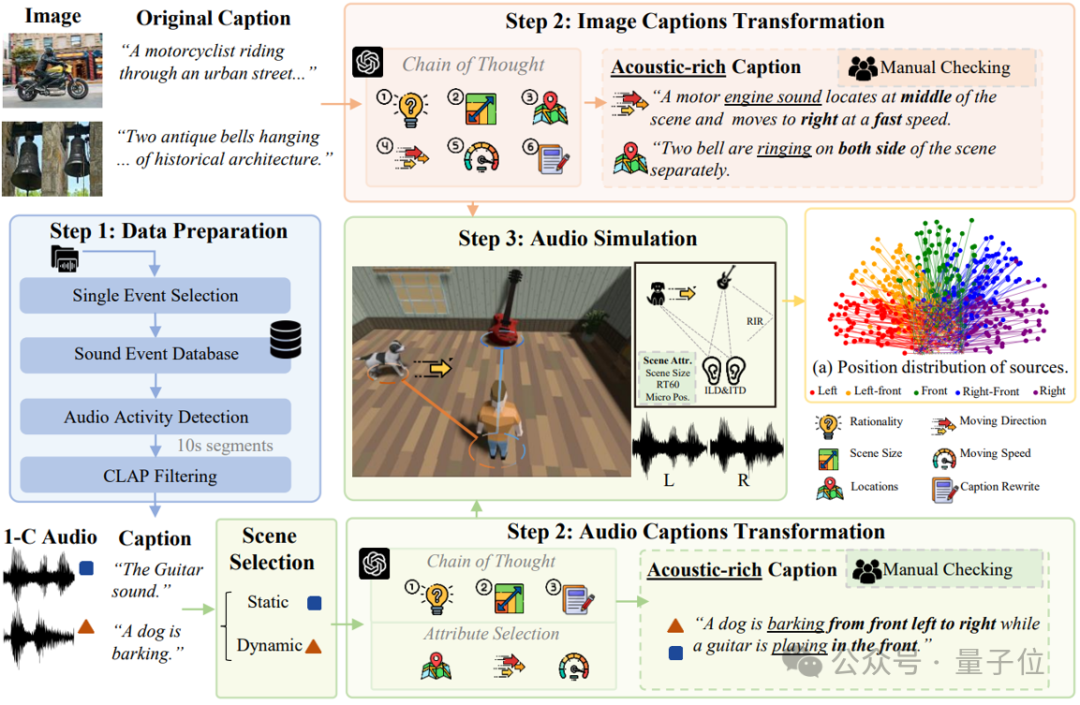

接下来,带民众揭秘BEWO-1M(Both Ears Wide Open 1M)数据集的“分娩活水线”。

为什么需要BEWO-1M?

现如今一般的音频-翰墨数据集都枯竭明确的空间信息描绘,比如即便有双通说念音频,配套的翰墨描绘也只是“汽车驶过”,而莫得具体场地信息(比如“汽车从右前列驶向左前列”)。这关于生成具有倡导感的空间音频十足不够用!

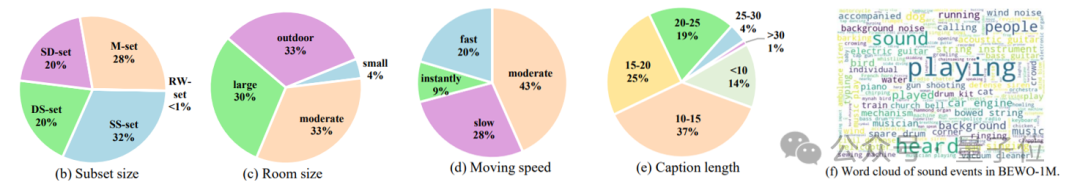

是以,需要一个超大限制的、带有丰富空间描绘的双通说念音频数据集,而 BEWO-1M 应时而生。它包含卓著100万条音频-文本对,况且因循动态声源、多声源等复杂场景。

借助近些年的热点的GPT-4和严谨的仿果然验,最终通过念念维链(Chain of Thought)构造了一个包含100万条、接洽约2800小时音频的大限制数据集,其中包括:

单声源静态音频子集(Single Stationary):比如“猫在左边叫”。

单声源动态音频子集(Single Dynamic):比如“直升机从左飞到右”。

多声源音频子集(Double, Mixed):比如“左侧有雷声,右侧有狗叫”。

果然宇宙音频子集(Real World):还手动标注了少部分果然录制的双通说念音频,确保测试集的果然性。

数据种种性一览:

BEWO-1M是当今首个包含倡导描绘的大限制双通说念音频数据集,它不仅适用于空间音频生成,还不错彭胀到空间音频字幕生成(Appendix.G.5)、音频-文本检索(Appendix.G.6)等其他任务。在实验中,发现它能够显耀栽植生成模子的空间终结才调,让机器果然作念到“耳听八方”。

生成门径简述

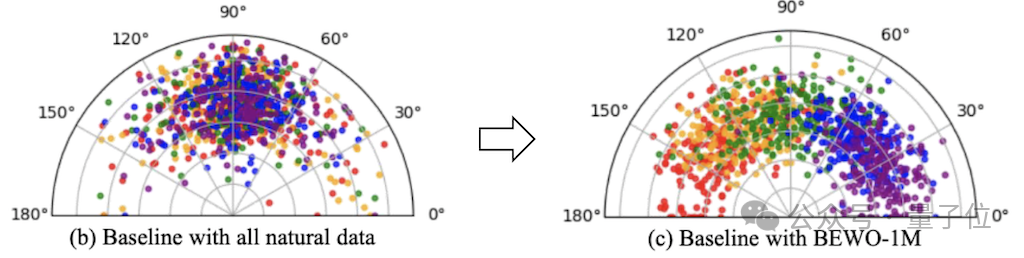

感谢Stability AI的接头者们,他们配置了用于生成双通说念的模子。然则这里生成模子存在比较显然的音频生成问题。比如:在Stable Audio中输入prompt “A piano sound exists on the left side”, 最毕生成的钢琴声息的倡导是不可控的。这是由于他们的双通说念音频十足由果然数据考研得到,方进取并不具有弥漫的种种性。是以可控倡导的音频生成模子近在眉睫。

有了BEWO-1M径直finetune行不可?行!径直使用带有场地天然言语的prompt,径直进行finetune就能够让模子获取最基本的生成指定倡导音频的才调。对此作家提供了一个通过天然言语终结的Gradio Demo.

然则波及到倡导天然言语透露的时候存在特殊种种化的抒发。这些种种化的抒发对文本的encoder带来了极大的挑战。关于T5这个特殊经典的编码模子来说,更长的文本长度会带来更长的编码和更大的透露难度。

那更进一局势,为了搪塞这么的挑战有两个特殊天然的想法。(1)将空间终结和文本终结解耦;(2)诈欺大模子关于文本的透露才调。

将空间终结和文本终结解耦.就意味着增多空间终结的指导!空间终结的竣当事者要来自仿真的考研数据,作家有极为准确的仿真建模,是以在考研时的角度是精确到少量点后4位的。那么在考研的时候使用这个角度瑕瑜常天然的。对此作家提供了一个通过精确场地信息终结的Gradio Demo.

诈欺大模子关于文本的透露才调不错在推理的时候用推理和高低文体习获取可靠的倡导信息(详见论文),这个倡导在东说念主工考证中正确率高达90%。

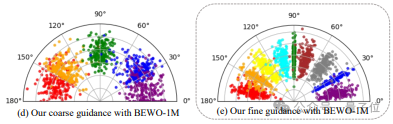

通过对空间终结和文本解耦竣事了如上图可视化的更精确的音频倡导的终结。其终结性能比拟径直finetune有了精确性的栽植。

实验流程中,作家发现要是使用极为准确的角度建模神志不错生成倡导较为准确的音频,然则生成的音频语义种种化欠佳。是以同期配置了coarse建模神志不错取得更种种化的音频生成,然则会出现倡导终结不准确的情况。

“种种性 or 终结” 这个生成千古贫窭依然在这里是个trade off。

有了基于多数文本音频对的数据得到的文本终结的模子?那么若何迁徙到其他模态上呢。而且文本编码用的是T5编码。

各人皆知,T5动作encoder+decoder的model在大模子的现今仍是淘汰了。接头团队通俗借助前东说念主的VL-T5接着作念了通俗的对皆竣事了通俗的image到spatial audio的生成,这只是是给社区提供一个通俗粗俗的图像指导的音频生成的baseline。

评价和效果

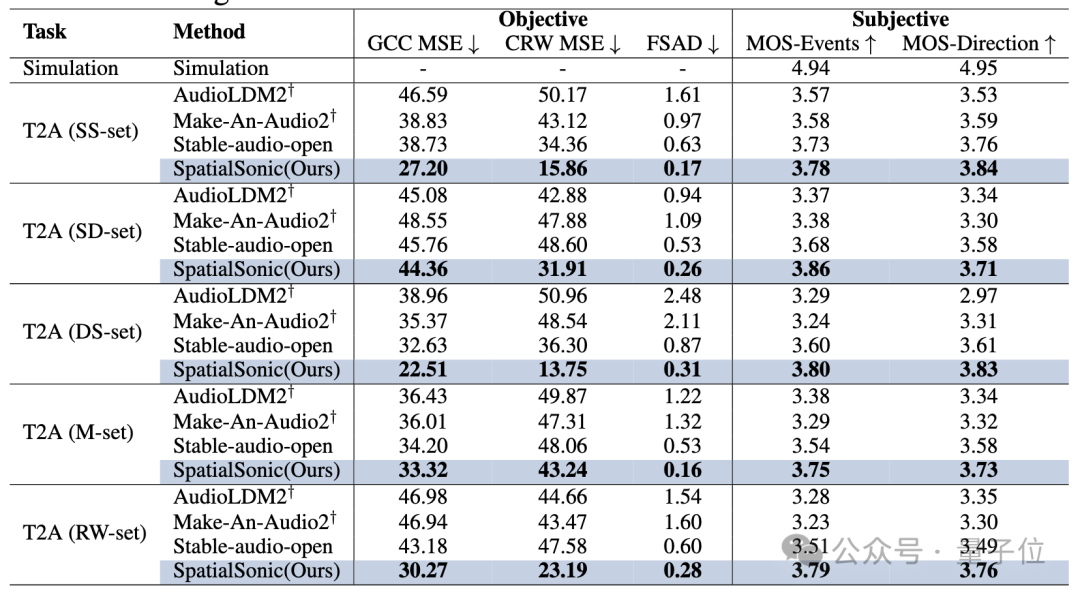

为了和其他模子比较,接头团队配置了多种语义和声源方进取的评估算法。

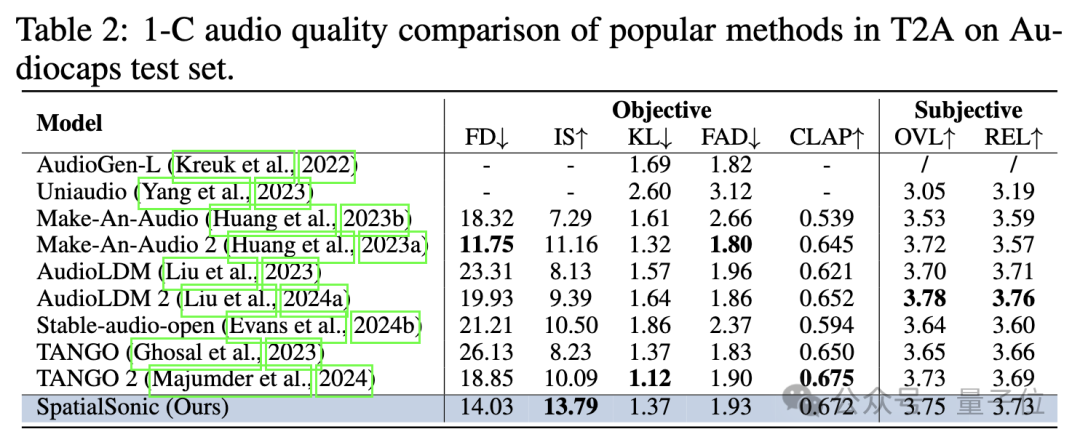

语义层面,此前Text2Audio的生成的评估算法依然灵验。作家径直声说念平均后评测语义层面上的相似进程。下表展示了以单通说念模子的评估方法评估SpatialSonic模子依然具有一定的先进性。

声源倡导层面,接头团队革命性地初度提议通过ITD求出场地差错。把柄布景所述,东说念主主要通过ITD来判断物体的大约场地,相同也经受ITD动作评估门径。

此前ITD的评估一般由2种门径而来:

传统信号门径:代表为GCC-Phat

深度学习门径:代表为StereoCRW

本文诈欺这两种ITD评估门径,配置了对两段音频的ITD进行不同进程的评估算法(GCC MSE、CRW MSE和FSAD)。通过这些接洽很好地展示了模子在文本指导的空间音频生成上的优胜性。

由于音频自身具有的耦合性,接头团队信赖这并不是生成音频ITD相似度的评估算法的最终格式。团队会束缚在GitHub上更新更优质的算法。更多的实验效果请参考论文。

要是你意思意思如下几个问题,请向论文中寻求谜底!

1、倡导的参与进程是否会影响音频的生成质料?(Appendix.G.9)

是的。作家发现加入倡导距离中间偏差越大,生成音频质料会迟缓着落。比如,质料上,纯左

2、由于倡导的加入,势必导致caption长度的增多,这是否会影响音频的生成质料?(Appendix.G.10)

是的。作家发现caption长度越长,生成质料会着落。

3、不同类别的终结倡导才调是否换取?是否存在一些类别声息终结倡导才调较强,一些较弱的Bias?(Appendix.G.11)

确乎不同。作家发现关于个别类终结才调较强,其他类终结才调稍弱。计算这与数据漫衍和GPT induction都存在关联。

往时预测

往时在以下多方面存在矫正空间:

引入HRTF模拟耳说念等果然感知。

面前Visual由于使用Coco数据集存在较强的in domain问题。OOD(Out of Distribution)或者OV (Open Vocabulary)会有特殊大的跳跃空间。

Interactive的竣事依赖于SAM的性能,竣事依然不瑕瑜常优雅且存在造作积存。

VL-T5早已逾期时间,概况动作初步探索弥漫,然则往时势必会有更优雅的神志。

— 完 —开yun体育网